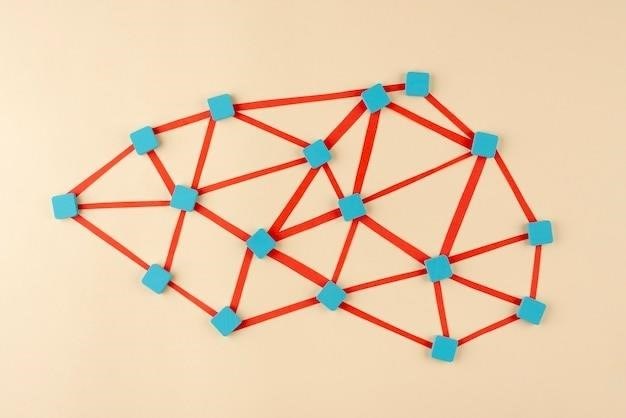

Процесс обучения нейронной сети – это итеративное изменение её внутренней структуры для достижения наилучшей производительности на задаче. Ключевым аспектом этого процесса является модификация параметров сети. Эти параметры включают в себя веса связей между нейронами, а в некоторых случаях и количество нейронов в слоях, а также количество самих слоев.

Изменение весов связей

Веса связей представляют собой числовые коэффициенты, определяющие силу влияния одного нейрона на другой. Они являются основными параметрами, которые изменяются при обучении. Изменение весов происходит на основе алгоритма обучения, чаще всего – обратного распространения ошибки (backpropagation). Этот алгоритм вычисляет градиент функции ошибки относительно весов и корректирует их, чтобы минимизировать ошибку.

Процесс обновления весов⁚

- Вычисление ошибки⁚ разница между предсказанным и истинным значением.

- Распространение ошибки назад⁚ распространение ошибки через сеть для вычисления градиента ошибки для каждого веса.

- Обновление весов⁚ коррекция весов пропорционально градиенту ошибки и скорости обучения (learning rate).

Скорость обучения – это гиперпараметр, определяющий размер шага коррекции весов. Слишком большая скорость обучения может привести к нестабильности обучения, а слишком малая – к замедлению процесса.

Изменение количества нейронов

В отличие от весов, количество нейронов в слоях обычно не изменяется во время обучения. Архитектура сети, включая количество нейронов и слоев, задаётся заранее. Однако существуют некоторые продвинутые техники, такие как нейронные сети с динамической архитектурой, где количество нейронов может изменяться в процессе обучения. Эти методы сложнее в реализации и требуют больше вычислительных ресурсов.

Изменение количества слоев

Аналогично количеству нейронов, количество слоев в сети обычно фиксируется перед началом обучения. Глубокое обучение (deep learning) использует сети с множеством слоёв, что позволяет им моделировать сложные зависимости в данных. Изменение количества слоев во время обучения – это сложная задача, которая обычно не применяется на практике.

При обучении нейронной сети главным образом изменяются веса связей между нейронами. Количество нейронов и слоев обычно остаются неизменными, хотя существуют и исключения, связанные со специфическими архитектурами и методами обучения. Выбор оптимальной архитектуры сети и параметров обучения – это важная задача, требующая экспериментов и анализа.

Оптимизация процесса обучения

Эффективность обучения нейронной сети во многом зависит от выбора метода оптимизации. Помимо градиентного спуска, который лежит в основе обратного распространения ошибки, существуют более продвинутые алгоритмы, такие как⁚

- Momentum⁚ учитывает историю изменений весов, что позволяет ускорить спуск в широких долинах функции ошибки и замедлить колебания в узких.

- RMSprop⁚ адаптирует скорость обучения для каждого веса, уменьшая колебания в направлениях с большим градиентом.

- Adam⁚ сочетает в себе преимущества Momentum и RMSprop, являясь одним из наиболее популярных алгоритмов оптимизации.

Выбор оптимального метода оптимизации зависит от конкретной задачи и архитектуры сети. Эксперименты с различными алгоритмами и настройками гиперпараметров (скорость обучения, момент импульса и др.) часто необходимы для достижения наилучших результатов.

Регуляризация

Для предотвращения переобучения (overfitting), когда сеть слишком хорошо запоминает обучающие данные, но плохо обобщает на новые, применяются методы регуляризации. К наиболее распространенным относятся⁚

- L1 и L2 регуляризация⁚ добавляют штрафные члены к функции ошибки, уменьшая значения весов.

- Dropout⁚ случайное отключение нейронов во время обучения, что заставляет сеть быть более устойчивой к шуму и менее зависимой от отдельных нейронов.

- Batch Normalization⁚ нормализация активаций нейронов, что стабилизирует процесс обучения и ускоряет сходимость.

Применение методов регуляризации позволяет улучшить обобщающую способность сети и повысить её производительность на новых, невидимых ранее данных.

Инициализация весов

Правильная инициализация весов также играет важную роль в процессе обучения. Неудачная инициализация может привести к медленной сходимости или к застреванию в локальных минимумах функции ошибки. Общие стратегии инициализации включают⁚

- Случайная инициализация⁚ веса инициализируются случайными числами из определенного распределения (например, нормального или равномерного).

- Xavier/Glorot инициализация⁚ специальные методы, которые учитывают размер входного и выходного слоев нейрона, обеспечивая более равномерное распространение активаций.

- He инициализация⁚ модификация Xavier инициализации, предназначенная для работы с функциями активации типа ReLU.

Выбор метода инициализации зависит от архитектуры сети и функции активации.

Обучение нейронной сети – сложный и многогранный процесс, требующий понимания различных аспектов, от изменения весов до выбора методов оптимизации и регуляризации. Грамотный подход к этим аспектам позволяет достичь высокой производительности и надежности созданной модели.

Было бы полезно добавить информацию о различных алгоритмах оптимизации, помимо градиентного спуска.

Не хватает примеров кода для иллюстрации описанных процессов. В целом, статья информативна и хорошо структурирована.

Отличный обзор процесса обучения. Подробно рассмотрены механизмы изменения весов и роли скорости обучения. Полезно для понимания работы нейросетей.

Статья написана доступным языком, легко читается и усваивается. Хорошее введение в тему для тех, кто только начинает изучать нейронные сети.

Статья хорошо структурирована, информация представлена логично и последовательно. Отличный материал для начального уровня.

Полезная статья, дающая общее представление о процессе обучения нейронных сетей. Рекомендую для ознакомления.

Замечательная статья! Всё ясно и понятно. Рекомендую всем, кто интересуется машинным обучением.

Статья хорошо объясняет базовые принципы обучения нейронных сетей. Понятное изложение материала, особенно для новичков.

Интересный обзор, но хотелось бы увидеть больше информации о динамических архитектурах нейронных сетей.