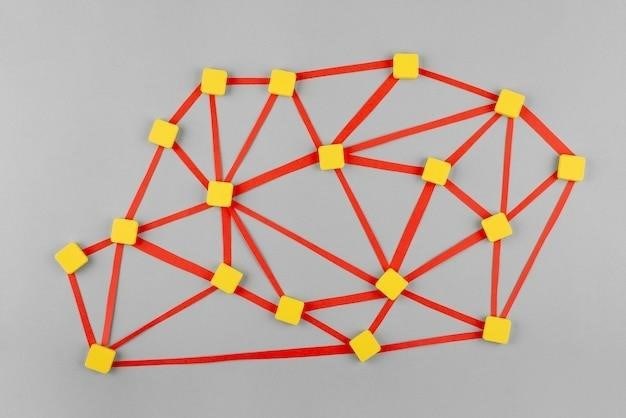

Модель нейронной сети – это абстрактное представление искусственной нейронной сети, определяющее ее структуру, функции и алгоритмы обучения. Она описывает, как сеть обрабатывает информацию, от входных данных до вывода результата. Понимание модели критически важно для разработки, обучения и применения нейронных сетей в различных задачах.

Архитектура и конфигурация

Архитектура модели определяет организацию нейронов и их взаимосвязей в сети; Основные элементы архитектуры включают⁚

- Входной слой⁚ принимает исходные данные.

- Скрытые слои⁚ выполняют сложные преобразования данных. Количество скрытых слоев и нейронов в каждом слое определяет сложность модели и ее способность к обучению.

- Выходной слой⁚ выдает результат обработки данных.

- Связи (синапсы)⁚ соединяют нейроны между слоями, каждая связь имеет свой вес, определяющий силу влияния одного нейрона на другой.

- Активационные функции⁚ применяются к выходу каждого нейрона, преобразуя его значение и внося нелинейность в модель.

Конфигурация модели включает конкретные параметры архитектуры, такие как количество нейронов в каждом слое, тип активационных функций, и другие гиперпараметры, влияющие на процесс обучения и производительность сети. Выбор оптимальной конфигурации зависит от задачи и данных.

Алгоритмы обучения

Модель нейронной сети не может работать сама по себе. Ей необходим процесс обучения, в ходе которого сеть настраивает веса связей между нейронами для минимизации ошибки между предсказанными и истинными значениями. Существует множество алгоритмов обучения, включая⁚

- Обратное распространение ошибки (Backpropagation)⁚ наиболее распространенный алгоритм, использующий градиентный спуск для оптимизации весов.

- Стохастический градиентный спуск (SGD)⁚ вариант градиентного спуска, использующий случайные подмножества данных для ускорения обучения.

- Адаптивный момент (Adam)⁚ оптимизатор, адаптирующий скорость обучения для каждого параметра.

Выбор алгоритма обучения зависит от сложности модели, размера данных и требований к скорости и точности обучения.

Типы моделей нейронных сетей

Существует множество типов нейронных сетей, каждый из которых предназначен для решения определенного класса задач. К наиболее распространенным относятся⁚

- Многослойный перцептрон (MLP)⁚ универсальный тип сети, применяемый для решения задач классификации и регрессии.

- Сверточные нейронные сети (CNN)⁚ специализированы на обработке изображений и видео.

- Рекуррентные нейронные сети (RNN)⁚ применяются для обработки последовательностей данных, таких как текст и временные ряды.

- Рекуррентные нейронные сети с долгой краткосрочной памятью (LSTM)⁚ улучшенный вариант RNN, способный обрабатывать длинные последовательности.

Выбор типа модели зависит от специфики решаемой задачи и особенностей данных.

Модель нейронной сети – это фундаментальное понятие в области искусственного интеллекта. Понимание ее архитектуры, конфигурации и алгоритмов обучения необходимо для успешного применения нейронных сетей в различных областях, от обработки изображений до анализа текста и прогнозирования временных рядов.

После того, как вы освоили базовые понятия модели нейронной сети, можно углубиться в более сложные аспекты. Это включает в себя⁚

1. Гиперпараметры и их настройка

Выбор оптимальных гиперпараметров – ключевой момент в построении эффективной нейронной сети. К ним относятся⁚

- Скорость обучения (learning rate)⁚ определяет шаг изменения весов сети во время обучения. Слишком большой шаг может привести к расхождению, слишком маленький – к замедлению обучения.

- Количество эпох (epochs)⁚ количество полных проходов по обучающей выборке.

- Размер батча (batch size)⁚ количество образцов, обрабатываемых за один шаг обучения.

- Функция активации⁚ выбор функции активации влияет на нелинейность сети и ее способность аппроксимировать сложные зависимости.

- Регуляризация⁚ методы предотвращения переобучения (overfitting), такие как dropout или L1/L2 регуляризация.

Настройка гиперпараметров часто осуществляется методом проб и ошибок, а также с помощью более продвинутых методов, таких как перекрестная валидация и поиск по сетке (grid search).

2. Более сложные архитектуры

Помимо базовых типов нейронных сетей, существуют более сложные архитектуры, разработанные для решения специфических задач⁚

- Трансформеры (Transformers)⁚ эффективны для обработки последовательностей, особенно в задачах обработки естественного языка.

- Генеративные состязательные сети (GANs)⁚ используются для генерации новых данных, похожих на обучающую выборку.

- Автокодировщики (Autoencoders)⁚ используются для уменьшения размерности данных и извлечения признаков.

- Сети глубокого обучения (Deep Learning)⁚ сети с большим количеством слоев, способные решать более сложные задачи.

3. Оптимизация и масштабирование

Обучение больших нейронных сетей может занимать значительное время и вычислительные ресурсы. Для оптимизации процесса обучения и масштабирования используются⁚

- Распараллеливание вычислений⁚ использование нескольких процессоров или графических процессоров (GPU) для ускорения обучения.

- Оптимизированные библиотеки⁚ такие как TensorFlow, PyTorch, позволяющие эффективно использовать вычислительные ресурсы.

- Методы распределенного обучения⁚ распределение обучения на множество машин для обработки больших объемов данных.

4. Оценка производительности

После обучения нейронной сети необходимо оценить ее производительность на тестовых данных. Для этого используются различные метрики, зависящие от типа задачи⁚

- Точность (Accuracy)⁚ доля правильно классифицированных образцов.

- Точность (Precision) и полнота (Recall)⁚ метрики, используемые в задачах классификации с несбалансированными классами.

- F1-мера (F1-score)⁚ гармоническое среднее точности и полноты.

- Среднеквадратичная ошибка (MSE)⁚ метрика, используемая в задачах регрессии.

Понимание этих аспектов позволит вам эффективно строить, обучать и применять нейронные сети для решения самых разнообразных задач.