Нейронные сети – это мощный инструмент искусственного интеллекта‚ вдохновленный структурой и функционированием биологического мозга. Они способны решать сложные задачи‚ такие как распознавание образов‚ обработка естественного языка и прогнозирование. Но как же они работают?

Архитектура нейронной сети

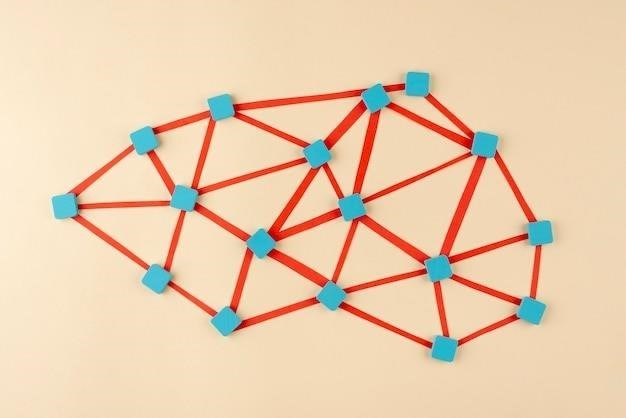

Основной строительный блок нейронной сети – это нейрон. Каждый нейрон принимает несколько входных сигналов‚ обрабатывает их и выдает один выходной сигнал. Обработка заключается в умножении каждого входного сигнала на соответствующий вес (числовое значение‚ отражающее важность данного сигнала)‚ суммировании результатов и применении активационной функции. Активационная функция преобразует сумму взвешенных входных сигналов в выходной сигнал нейрона‚ часто ограничивая его диапазон значений (например‚ от 0 до 1 или от -1 до 1).

Нейроны организованы в слои. Типичная нейронная сеть состоит из⁚

- Входного слоя⁚ принимает исходные данные (например‚ пиксели изображения или слова текста).

- Скрытых слоев⁚ выполняют промежуточные вычисления. Количество скрытых слоев и нейронов в каждом слое определяет сложность сети.

- Выходного слоя⁚ выдает результат обработки (например‚ классификацию изображения или перевод текста).

Связи между нейронами разных слоев представляют собой синапсы‚ каждый из которых имеет свой вес. Эти веса являются параметрами сети‚ которые настраиваются в процессе обучения.

Процесс обучения

Обучение нейронной сети заключается в настройке весов синапсов так‚ чтобы сеть минимизировала ошибку между своими предсказаниями и истинными значениями. Это достигается с помощью алгоритмов обратного распространения ошибки (backpropagation). Суть алгоритма заключается в следующем⁚

- Прямое распространение⁚ входные данные передаются через сеть‚ и сеть выдает свой прогноз.

- Вычисление ошибки⁚ сравнивается прогноз сети с истинным значением‚ и вычисляется ошибка.

- Обратное распространение ошибки⁚ ошибка распространяется обратно через сеть‚ и веса синапсов корректируются пропорционально их вкладу в ошибку. Этот процесс использует градиентный спуск для поиска оптимальных весов.

- Повторение⁚ шаги 1-3 повторяются многократно на большом объеме данных (тренировочном наборе)‚ пока ошибка не достигнет приемлемого уровня.

Типы нейронных сетей

Существует множество типов нейронных сетей‚ каждый из которых подходит для решения определенного класса задач. К наиболее распространенным относятся⁚

- Многослойные персептроны (MLP)⁚ полносвязные сети с одним или несколькими скрытыми слоями.

- Сверточные нейронные сети (CNN)⁚ специально разработаны для обработки изображений и видео.

- Рекуррентные нейронные сети (RNN)⁚ используются для обработки последовательностей данных‚ таких как текст и временные ряды.

- Рекуррентные нейронные сети с долгой краткосрочной памятью (LSTM)⁚ модификация RNN‚ способная обрабатывать длинные последовательности данных.

Нейронные сети – это сложные‚ но мощные инструменты‚ которые позволяют решать задачи‚ недоступные классическим алгоритмам. Их принцип работы основан на обработке информации параллельно множеством простых вычислительных элементов (нейронов)‚ связанных между собой и настраиваемых в процессе обучения. Разнообразие архитектур и алгоритмов обучения позволяет применять нейронные сети в самых разных областях‚ от медицины до финансов.

Рассмотрим подробнее некоторые аспекты работы нейронных сетей‚ не затронутые в предыдущем описании.

Активационные функции

Выбор активационной функции критически важен для эффективности нейронной сети. Разные функции обладают различными свойствами‚ влияющими на способность сети обучаться и обрабатывать информацию. Например⁚

- Сигмоида⁚ выдает значение в диапазоне от 0 до 1‚ хорошо подходит для бинарной классификации‚ но страдает от проблемы затухающего градиента в глубоких сетях.

- ReLU (Rectified Linear Unit)⁚ выдает значение 0 для отрицательных входных данных и само входное значение для положительных. Быстрее обучается‚ чем сигмоида‚ и решает проблему затухающего градиента‚ но может страдать от проблемы “мертвых нейронов”.

- Tanh (гиперболический тангенс)⁚ выдает значение в диапазоне от -1 до 1‚ похожа на сигмоиду‚ но центрирована вокруг 0.

- Softmax⁚ преобразует вектор входных данных в вероятностное распределение‚ часто используется в выходном слое для многоклассовой классификации.

Выбор оптимальной активационной функции зависит от конкретной задачи и архитектуры сети.

Оптимизаторы

Оптимизаторы – это алгоритмы‚ используемые для нахождения оптимальных весов нейронной сети. Они определяют‚ как сеть будет корректировать свои веса на каждом шаге обучения. Примеры оптимизаторов⁚

- Градиентный спуск⁚ основной алгоритм‚ направляет изменение весов в сторону уменьшения ошибки.

- Стохастический градиентный спуск (SGD)⁚ использует случайные подмножества данных для вычисления градиента‚ что ускоряет обучение и помогает избежать попадания в локальные минимумы.

- Adam⁚ адаптивный оптимизатор‚ автоматически настраивает скорость обучения для каждого веса.

- RMSprop⁚ еще один адаптивный оптимизатор‚ фокусируется на уменьшении колебаний скорости обучения.

Выбор оптимизатора также влияет на скорость и качество обучения.

Регуляризация

Регуляризация – это набор методов‚ предотвращающих переобучение нейронной сети. Переобучение происходит‚ когда сеть слишком хорошо запоминает тренировочные данные и плохо обобщает на новые данные. Методы регуляризации⁚

- Dropout⁚ случайное отключение нейронов во время обучения‚ что заставляет сеть обучаться более устойчивым признакам.

- L1 и L2 регуляризация⁚ добавление штрафных членов к функции потерь‚ которые ограничивают значения весов.

- Ранняя остановка⁚ прекращение обучения‚ когда ошибка на валидационных данных начинает расти.

Оценка производительности

После обучения необходимо оценить производительность нейронной сети. Для этого используются различные метрики‚ зависящие от типа задачи⁚

- Точность (Accuracy)⁚ процент правильно классифицированных образцов.

- Точность (Precision)⁚ доля правильно предсказанных положительных образцов среди всех предсказанных положительных.

- Полнота (Recall)⁚ доля правильно предсказанных положительных образцов среди всех истинных положительных.

- F1-мера⁚ гармоническое среднее точности и полноты.

- AUC-ROC⁚ площадь под кривой ROC (Receiver Operating Characteristic)‚ характеризует способность модели различать классы.

Правильный выбор метрик и способов оценки производительности критичен для объективной оценки качества работы нейронной сети.

Статья хорошо объясняет базовые принципы работы нейронных сетей. Понятное описание архитектуры и процесса обучения. Однако, для более глубокого понимания, не помешало бы добавить примеры конкретных архитектур (например, CNN, RNN).

Статья дает общее представление о нейронных сетях. Для более полного понимания необходимо углубиться в математические основы и алгоритмы. В целом, хороший обзор для первого знакомства с темой.

Хорошо написано, но отсутствует обсуждение проблем, связанных с обучением нейронных сетей, таких как переобучение и недообучение. Это важный аспект, который стоит упомянуть.

Статья немного поверхностная. Не хватает информации о различных типах нейронных сетей и их применении на практике. Было бы полезно добавить ссылки на дополнительные ресурсы.

Замечательная статья для начинающих! Ясно и лаконично объясняются сложные понятия. Иллюстрации или схемы значительно бы улучшили восприятие материала.

Отличное введение в тему нейронных сетей! Доступно и понятно изложено даже для тех, кто не знаком с математикой. Хорошо структурировано, легко читается.