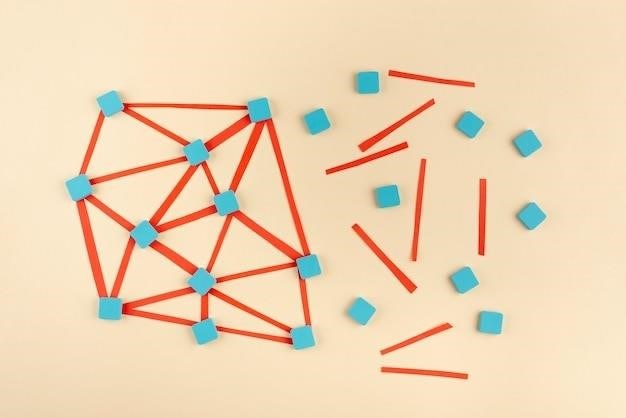

В подавляющем большинстве современных нейронных сетей используется градиентный спуск в сочетании с обратным распространением ошибки (backpropagation). Это не единый алгоритм, а скорее пара взаимодополняющих методов, работающих вместе для оптимизации весов нейронной сети.

Градиентный спуск⁚ поиск минимума функции потерь

Цель обучения нейронной сети — минимизировать функцию потерь (loss function), которая измеряет разницу между прогнозами сети и истинными значениями. Градиентный спуск — это итеративный алгоритм, который находит минимум этой функции. Он работает путем вычисления градиента функции потерь (вектор, указывающий направление наискорейшего возрастания функции) и перемещения весов сети в противоположном направлении (направление наискорейшего убывания). Шаг перемещения регулируется параметром, называемым скоростью обучения (learning rate).

Варианты градиентного спуска⁚

- Стохастический градиентный спуск (SGD)⁚ обновляет веса после обработки каждого отдельного примера из обучающего набора. Быстрый, но может быть нестабильным.

- Пакетный градиентный спуск (Batch GD)⁚ обновляет веса после обработки всего обучающего набора. Стабильный, но медленный для больших наборов данных.

- Мини-пакетный градиентный спуск (Mini-batch GD)⁚ компромисс между SGD и Batch GD. Обновляет веса после обработки небольших подмножеств (мини-пакетов) обучающего набора. Наиболее распространенный вариант.

Обратное распространение ошибки⁚ вычисление градиента

Обратное распространение ошибки — это алгоритм, который эффективно вычисляет градиент функции потерь относительно весов нейронной сети. Он использует цепное правило дифференцирования для распространения ошибки от выходного слоя обратно через все слои сети, позволяя вычислить, как каждый вес влияет на общую ошибку. Это позволяет градиентному спуску эффективно корректировать веса для минимизации функции потерь.

Другие алгоритмы обучения

Хотя градиентный спуск с обратным распространением ошибки является доминирующим методом, существуют и другие алгоритмы обучения нейронных сетей, которые используются в специфических случаях или для решения определенных проблем. К ним относятся⁚

- Адаптивные методы оптимизации⁚ Adam, RMSprop, AdaGrad – модификации градиентного спуска, которые автоматически настраивают скорость обучения для каждого веса.

- Методы второго порядка⁚ используют информацию о кривизне функции потерь для более эффективного поиска минимума. Вычислительно сложнее, чем градиентный спуск.

- Эволюционные алгоритмы⁚ генетические алгоритмы и другие эволюционные методы могут использоваться для обучения нейронных сетей, особенно в задачах с высокой размерностью пространства параметров.

Выбор конкретного алгоритма обучения зависит от задачи, размера обучающего набора данных, архитектуры нейронной сети и других факторов. Однако, градиентный спуск с обратным распространением ошибки остается основой для большинства современных нейронных сетей.

Хотя градиентный спуск и его вариации являются основой обучения большинства нейронных сетей, полная картина обучения значительно сложнее и включает в себя множество дополнительных факторов, влияющих на эффективность и стабильность процесса. Рассмотрим некоторые из них⁚

Выбор функции активации

Функция активации определяет нелинейность нейрона и, следовательно, всей сети. Выбор неправильной функции активации может привести к проблемам с обучением, таким как затухание градиента (vanishing gradient) или взрыв градиента (exploding gradient). Популярные функции активации включают в себя сигмоиду, ReLU (Rectified Linear Unit), Leaky ReLU, ELU (Exponential Linear Unit) и другие. Выбор оптимальной функции активации часто зависит от конкретной архитектуры сети и задачи.

Регуляризация

Регуляризация используется для предотвращения переобучения (overfitting), когда модель слишком хорошо запоминает обучающие данные и плохо обобщает на новые данные. Общие методы регуляризации включают в себя⁚

- L1 и L2 регуляризация⁚ добавляют штрафные члены к функции потерь, которые наказывают большие веса. L1 регуляризация способствует разреженности весов (многие веса становятся равными нулю), в то время как L2 регуляризация способствует меньшим, но ненулевым весам.

- Dropout⁚ случайное отключение нейронов во время обучения, что вынуждает сеть учиться более робастным признакам.

- Early stopping⁚ остановка обучения, когда производительность на валидационном наборе начинает ухудшаться.

Инициализация весов

Правильная инициализация весов сети играет важную роль в скорости и эффективности обучения. Плохая инициализация может привести к застреванию в локальных минимумах или к очень медленному обучению. Существуют различные стратегии инициализации, такие как инициализация Хе (Xavier) и инициализация He (для ReLU активаций).

Нормализация данных

Нормализация входных данных (например, приведение их к нулевому среднему и единичной дисперсии) может значительно улучшить скорость и стабильность обучения. Это особенно важно для сетей с градиентным спуском, так как он чувствителен к масштабу входных данных.

Оптимизация гиперпараметров

Гиперпараметрами называются параметры, которые не обучаются во время процесса обучения, но влияют на него. К ним относятся скорость обучения, размер мини-пакета, коэффициенты регуляризации и другие. Оптимизация гиперпараметров — это сложная задача, для которой используются различные методы, такие как поиск по сетке (grid search), случайный поиск (random search) и байесовская оптимизация.

Архитектура нейронной сети

Выбор архитектуры нейронной сети (количество слоев, количество нейронов в каждом слое, тип слоев) критически важен для успешного обучения. Различные архитектуры подходят для различных задач. Например, сверточные нейронные сети (CNN) хорошо подходят для обработки изображений, а рекуррентные нейронные сети (RNN) — для обработки последовательностей.

Текст написан четко и структурировано. Хорошо раскрыта взаимосвязь между градиентным спуском и обратным распространением ошибки.

Статья хорошо объясняет основные принципы градиентного спуска и обратного распространения ошибки. Понятное и доступное изложение сложной темы.

Хороший обзор основных методов оптимизации в нейронных сетях. Позволяет получить общее представление о теме.

Полезная информация для понимания работы нейронных сетей. Хотелось бы увидеть больше примеров и иллюстраций.

Статья хорошо структурирована, легко читается. Информация представлена системно и логично.

Кратко, ясно и по существу. Рекомендую для ознакомления с базовыми концепциями.

Отличный обзор! Наглядно показаны различия между вариантами градиентного спуска. Полезно для начинающих в области машинного обучения.

Информация актуальна и полезна. Хорошо подходит для студентов и специалистов, изучающих машинное обучение.