Обучение нейронной сети – это сложный процесс, цель которого — научить сеть распознавать паттерны, делать предсказания или принимать решения на основе входных данных. Это достигается путем настройки внутренних параметров сети, называемых весами и смещениями. Процесс обучения можно разделить на несколько ключевых этапов и методов, каждый из которых играет важную роль в достижении желаемой производительности.

Основные методы обучения

Существует несколько основных парадигм обучения нейронных сетей⁚

- Обучение с учителем (Supervised Learning)⁚ Сеть обучается на наборе данных, где каждому входному примеру сопоставлен желаемый выходной результат (метка). Алгоритм корректирует веса сети, минимизируя разницу между предсказанными и истинными значениями. Обратное распространение ошибки (Backpropagation) является наиболее распространенным алгоритмом обучения с учителем.

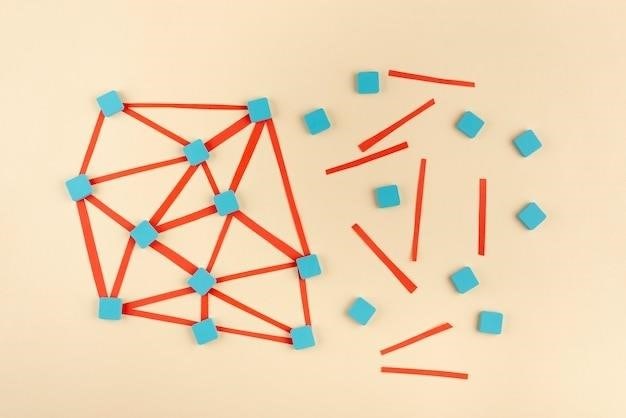

- Обучение без учителя (Unsupervised Learning)⁚ Сеть обучается на наборе данных без меток. Цель – обнаружить скрытые структуры, закономерности и взаимосвязи в данных. Примеры включают кластеризацию (k-means, DBSCAN) и уменьшение размерности (PCA, t-SNE).

- Обучение с подкреплением (Reinforcement Learning)⁚ Сеть (агент) взаимодействует с окружающей средой, получая вознаграждения или штрафы за свои действия. Цель – научиться выбирать действия, максимизирующие накопленное вознаграждение. Этот метод используется в робототехнике, играх и других областях, где взаимодействие с окружающей средой играет ключевую роль.

- Трансферное обучение (Transfer Learning)⁚ Используются знания, полученные при обучении на одной задаче, для улучшения производительности на другой, похожей задаче. Это позволяет сократить время и ресурсы, необходимые для обучения на новых данных.

Алгоритмы обучения

Выбор алгоритма обучения зависит от типа задачи и набора данных. Рассмотрим некоторые популярные алгоритмы⁚

Обратное распространение ошибки (Backpropagation)

Это наиболее распространенный алгоритм обучения с учителем. Он включает в себя два основных шага⁚

- Прямое распространение⁚ Входные данные передаются через сеть, и вычисляется выходное значение.

- Обратное распространение⁚ Вычисляется ошибка между предсказанным и истинным значением. Ошибка распространяется назад через сеть, и веса корректируются, чтобы уменьшить ошибку. Этот процесс повторяется многократно до достижения сходимости.

Эффективность backpropagation зависит от выбора функции активации, функции потерь и алгоритма оптимизации.

Rprop (Resilient Backpropagation)

Модификация backpropagation, которая адаптирует скорость обучения для каждого веса индивидуально. Это позволяет избежать проблем, связанных с выбором глобальной скорости обучения.

Adam (Adaptive Moment Estimation)

Популярный алгоритм оптимизации, который использует информацию о первых и вторых моментах градиентов для адаптивной настройки скорости обучения для каждого веса.

RMSprop (Root Mean Square Propagation)

Еще один адаптивный алгоритм оптимизации, который усредняет квадраты градиентов для регулирования скорости обучения.

Этапы обучения нейронной сети

- Подготовка данных⁚ Сбор, очистка, предобработка и разделение данных на обучающие, валидационные и тестовые наборы.

- Выбор архитектуры сети⁚ Определение количества слоев, нейронов в каждом слое, типа функции активации и других параметров сети.

- Выбор алгоритма обучения⁚ Выбор подходящего алгоритма обучения в зависимости от задачи и данных.

- Обучение сети⁚ Итеративное обучение сети на обучающих данных, используя выбранный алгоритм.

- Валидация модели⁚ Оценка производительности сети на валидационных данных для предотвращения переобучения.

- Тестирование модели⁚ Оценка окончательной производительности сети на тестовых данных.

Выбор оптимальных параметров и алгоритмов – это итеративный процесс, требующий экспериментов и анализа результатов.

Более детальный обзор алгоритмов

Рассмотрим подробнее некоторые из упомянутых алгоритмов и добавим новые, важные для понимания полной картины обучения нейронных сетей⁚

Стохастический градиентный спуск (Stochastic Gradient Descent ⎻ SGD)

В отличие от пакетного градиентного спуска (Batch Gradient Descent), который использует всю обучающую выборку для вычисления градиента на каждом шаге, SGD использует лишь один или небольшую подвыборку (мини-пакет) образцов. Это делает процесс обучения значительно быстрее и позволяет обрабатывать большие объемы данных. Однако, из-за стохастичности (случайности) процесса, путь к минимуму функции потерь становится более шумным, что может замедлить сходимость, но часто помогает избежать попадания в локальные минимумы.

Модификации SGD

Для улучшения сходимости SGD были разработаны различные модификации⁚

- Momentum⁚ Добавляет инерцию к обновлению весов, учитывая предыдущие шаги градиентного спуска. Это помогает преодолевать небольшие “ямки” на поверхности функции потерь и ускоряет сходимость в направлениях с постоянным градиентом.

- Nesterov Accelerated Gradient (NAG)⁚ Усовершенствованная версия Momentum, которая “заглядывает вперед” перед обновлением весов, что позволяет избежать слишком резких изменений.

- Adagrad (Adaptive Gradient Algorithm)⁚ Адаптивно регулирует скорость обучения для каждого веса, уменьшая ее для весов с большими градиентами. Это полезно для данных с разреженными признаками.

- Adadelta⁚ Улучшение Adagrad, которое решает проблему постоянно уменьшающейся скорости обучения.

- Adam (Adaptive Moment Estimation)⁚ Комбинирует преимущества Momentum и Adagrad, обеспечивая быструю сходимость и адаптацию к различным типам данных.

- RMSprop (Root Mean Square Propagation)⁚ Подобен Adam, но проще в реализации и часто показывает хорошую эффективность.

Алгоритмы второго порядка

В отличие от методов первого порядка (SGD и его модификации), которые используют только градиент, алгоритмы второго порядка учитывают также информацию о матрице Гессе (матрица вторых производных). Это позволяет им достигать более быстрой сходимости, но требует значительно больших вычислительных ресурсов. Примеры включают в себя метод Ньютона и его модификации (квази-Ньютоновские методы, такие как L-BFGS).

Другие важные аспекты обучения

- Регуляризация⁚ Методы, предотвращающие переобучение (overfitting), например, L1 и L2 регуляризация (добавление штрафных членов к функции потерь).

- Dropout⁚ Метод регуляризации, который случайным образом отключает нейроны во время обучения, предотвращая чрезмерную зависимость от отдельных нейронов.

- Ранняя остановка (Early Stopping)⁚ Прекращение обучения, когда производительность на валидационном наборе начинает ухудшаться.

- Нормализация данных⁚ Преобразование данных для улучшения сходимости и производительности алгоритмов обучения (например, стандартизация или нормализация min-max).

Выбор оптимального алгоритма обучения нейронной сети зависит от множества факторов, включая размер и тип данных, архитектуру сети, вычислительные ресурсы и требуемую точность. Часто необходимы эксперименты с различными алгоритмами и их параметрами для достижения наилучших результатов. Понимание принципов работы различных алгоритмов и методов регуляризации является ключом к успешному обучению нейронных сетей.

Полезный материал для тех, кто хочет получить общее представление об обучении нейронных сетей. Хорошо структурировано и легко читается.

Информация представлена ясно и понятно. Примеры алгоритмов помогают лучше усвоить материал. Не хватает, пожалуй, практических примеров кода.

Статья достаточно полная, но могла бы быть более глубокой в плане математического обоснования алгоритмов.

Статья написана доступным языком, хорошо структурирована и охватывает основные методы обучения нейронных сетей. Полезно для начинающих.

Статья хорошо подходит для начального уровня. Ясно и понятно объясняются сложные понятия.

Неплохо, но хотелось бы увидеть больше информации о современных методах обучения, например, о глубоком обучении.

Замечательная статья для общего ознакомления с методами обучения нейронных сетей. Хорошо подходит для студентов.

Отличный обзор! Подробно рассмотрены различные подходы к обучению нейросетей. Рекомендую всем, кто интересуется этой темой.