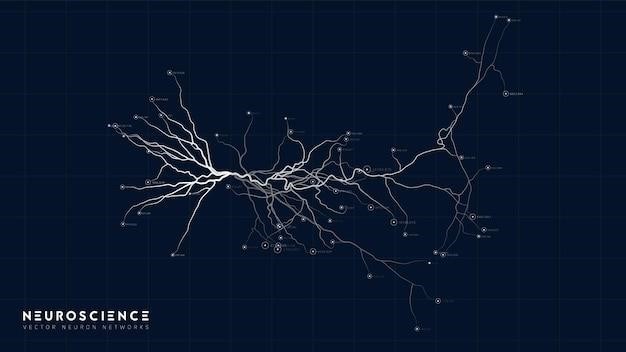

Нейронные сети – это мощный инструмент машинного обучения, вдохновленный структурой и функционированием человеческого мозга․ Они состоят из множества взаимосвязанных узлов, называемых нейронами, организованных в слои․ Понимание схемы и архитектуры нейронной сети является ключом к эффективному использованию этого инструмента․

Основные компоненты нейронной сети

Типичная нейронная сеть включает в себя следующие компоненты⁚

- Входной слой (Input Layer)⁚ Принимает входные данные․ Каждый нейрон в этом слое представляет собой один атрибут входных данных․ Например, при распознавании изображений каждый нейрон может представлять значение пикселя․

- Скрытые слои (Hidden Layers)⁚ Обрабатывают входные данные и извлекают из них сложные признаки․ Количество скрытых слоев и нейронов в каждом слое определяет сложность сети․ Более глубокие сети (с большим количеством скрытых слоев) способны моделировать более сложные зависимости в данных․

- Выходной слой (Output Layer)⁚ Выдает результат обработки․ Количество нейронов в выходном слое зависит от задачи․ Например, при бинарной классификации (да/нет) нужен один нейрон, а при многоклассовой классификации (например, распознавание цифр от 0 до 9) – десять нейронов․

- Веса (Weights)⁚ Каждая связь между нейронами имеет вес, который определяет силу влияния одного нейрона на другой․ Обучение нейронной сети заключается в настройке этих весов для минимизации ошибки․

- Активационные функции (Activation Functions)⁚ Применяются к выходу каждого нейрона, чтобы ввести нелинейность в модель․ Без активационных функций нейронная сеть была бы эквивалентна линейной регрессии․

Типы архитектур нейронных сетей

Существует множество различных архитектур нейронных сетей, каждая из которых подходит для решения определенных типов задач․ Вот некоторые из наиболее распространенных⁚

1; Полносвязные сети (Fully Connected Networks, FCN)

В полносвязных сетях каждый нейрон в одном слое соединен со всеми нейронами в следующем слое․ Они просты в реализации, но могут быть неэффективными для обработки больших объемов данных с высокой размерностью․

2․ Сверточные нейронные сети (Convolutional Neural Networks, CNN)

CNN особенно эффективны для обработки данных с пространственной структурой, таких как изображения и видео․ Они используют сверточные операции для извлечения локальных признаков из данных․

3․ Рекуррентные нейронные сети (Recurrent Neural Networks, RNN)

RNN предназначены для обработки последовательных данных, таких как текст и временные ряды․ Они имеют циклические связи, позволяющие им учитывать информацию из предыдущих шагов․

4․ Рекурсивные нейронные сети (Recursive Neural Networks)

Рекурсивные нейронные сети используются для обработки иерархических данных, таких как деревья синтаксического разбора․

5․ Генеративные состязательные сети (Generative Adversarial Networks, GAN)

GAN состоят из двух сетей⁚ генератора, который создает новые данные, и дискриминатора, который пытается отличить сгенерированные данные от реальных․ Они используются для генерации новых изображений, текста и других типов данных․

6․ Трансформеры (Transformers)

Трансформеры – относительно новая архитектура, которая использует механизм внимания (attention mechanism) для обработки последовательных данных․ Они показали высокую эффективность в задачах обработки естественного языка․

Обучение нейронной сети

Обучение нейронной сети заключается в настройке весов между нейронами для минимизации ошибки на обучающем наборе данных․ Это обычно делается с помощью алгоритмов обратного распространения ошибки (backpropagation)․

Выбор подходящей архитектуры и алгоритма обучения зависит от конкретной задачи и доступных данных․ Экспериментирование и настройка гиперпараметров играют ключевую роль в достижении оптимальных результатов․

Предыдущий раздел затронул основные типы нейронных сетей․ Однако, понимание их работы требует более глубокого погружения в детали․ Давайте рассмотрим некоторые ключевые аспекты архитектуры и обучения нейронных сетей более подробно․

Выбор архитектуры нейронной сети напрямую влияет на ее способность решать конкретную задачу․ Помимо типов, упомянутых ранее, существуют множество вариаций и гибридных моделей․ Например⁚

- Сети с глубокими остаточными связями (ResNet)⁚ Решают проблему исчезающего градиента в глубоких сетях, используя остаточные блоки, которые позволяют информации напрямую проходить через несколько слоев․ Это позволяет обучать значительно более глубокие сети, чем это было возможно ранее․

- Сети с вниманием (Attention Networks)⁚ Позволяют сети фокусироваться на наиболее важных частях входных данных, игнорируя менее значимую информацию․ Это особенно полезно в задачах обработки естественного языка и компьютерного зрения․

- Автоэнкодеры (Autoencoders)⁚ Используются для обучения представлений данных в низкоразмерном пространстве․ Они состоят из двух частей⁚ кодировщика (encoder), который сжимает данные, и декодера (decoder), который восстанавливает исходные данные из сжатого представления․ Применяются для задач уменьшения размерности, деноизинга и генерации данных․

- Сети Хопфилда (Hopfield Networks)⁚ Это тип рекуррентных сетей, используемых для ассоциативной памяти․ Они способны восстанавливать полное изображение на основе его частичного представления․

- Капсульные сети (Capsule Networks)⁚ Представляют собой относительно новый подход, который пытается решить проблему инвариантности к поворотам и масштабу в изображениях․ Они используют “капсулы” – группы нейронов, которые кодируют не только наличие объекта, но и его позицию и ориентацию․

Процесс обучения нейронной сети – это итеративный процесс, целью которого является минимизация функции потерь (loss function)․ Ключевые аспекты обучения включают⁚

- Функция активации⁚ Определяет выходной сигнал нейрона․ Популярные функции активации включают ReLU (Rectified Linear Unit), sigmoid, tanh и softmax․

- Функция потерь⁚ Измеряет разницу между предсказанными и истинными значениями․ Выбор функции потерь зависит от типа задачи (например, среднеквадратичная ошибка для регрессии, кросс-энтропия для классификации)․

- Оптимизатор⁚ Алгоритм, используемый для обновления весов нейронной сети․ Популярные оптимизаторы включают градиентный спуск (Gradient Descent), Adam, RMSprop и SGD (Stochastic Gradient Descent)․

- Регуляризация⁚ Методы, используемые для предотвращения переобучения (overfitting)․ К ним относятся dropout, L1 и L2 регуляризация․

- Нормализация данных⁚ Преобразование данных для улучшения процесса обучения․ Часто используется нормализация данных (например, z-score normalization)․

- Подбор гиперпараметров⁚ Настройка параметров обучения, таких как скорость обучения (learning rate), размер батча (batch size) и количество эпох (epochs)․ Этот процесс часто требует экспериментирования и использования методов поиска гиперпараметров (например, Grid Search, Random Search)․

Понимание этих аспектов критически важно для успешного обучения нейронных сетей и достижения высоких результатов в различных задачах․

Предыдущий раздел затронул основные типы нейронных сетей․ Однако, понимание их работы требует более глубокого погружения в детали․ Давайте рассмотрим некоторые ключевые аспекты архитектуры и обучения нейронных сетей более подробно․

Архитектурные особенности

Выбор архитектуры нейронной сети напрямую влияет на ее способность решать конкретную задачу․ Помимо типов, упомянутых ранее, существуют множество вариаций и гибридных моделей․ Например⁚

- Сети с глубокими остаточными связями (ResNet)⁚ Решают проблему исчезающего градиента в глубоких сетях, используя остаточные блоки, которые позволяют информации напрямую проходить через несколько слоев․ Это позволяет обучать значительно более глубокие сети, чем это было возможно ранее․

- Сети с вниманием (Attention Networks)⁚ Позволяют сети фокусироваться на наиболее важных частях входных данных, игнорируя менее значимую информацию․ Это особенно полезно в задачах обработки естественного языка и компьютерного зрения․

- Автоэнкодеры (Autoencoders)⁚ Используются для обучения представлений данных в низкоразмерном пространстве․ Они состоят из двух частей⁚ кодировщика (encoder), который сжимает данные, и декодера (decoder), который восстанавливает исходные данные из сжатого представления․ Применяются для задач уменьшения размерности, деноизинга и генерации данных․

- Сети Хопфилда (Hopfield Networks)⁚ Это тип рекуррентных сетей, используемых для ассоциативной памяти․ Они способны восстанавливать полное изображение на основе его частичного представления․

- Капсульные сети (Capsule Networks)⁚ Представляют собой относительно новый подход, который пытается решить проблему инвариантности к поворотам и масштабу в изображениях; Они используют “капсулы” – группы нейронов, которые кодируют не только наличие объекта, но и его позицию и ориентацию․

Аспекты обучения

Процесс обучения нейронной сети – это итеративный процесс, целью которого является минимизация функции потерь (loss function)․ Ключевые аспекты обучения включают⁚

- Функция активации⁚ Определяет выходной сигнал нейрона․ Популярные функции активации включают ReLU (Rectified Linear Unit), sigmoid, tanh и softmax․

- Функция потерь⁚ Измеряет разницу между предсказанными и истинными значениями․ Выбор функции потерь зависит от типа задачи (например, среднеквадратичная ошибка для регрессии, кросс-энтропия для классификации)․

- Оптимизатор⁚ Алгоритм, используемый для обновления весов нейронной сети․ Популярные оптимизаторы включают градиентный спуск (Gradient Descent), Adam, RMSprop и SGD (Stochastic Gradient Descent)․

- Регуляризация⁚ Методы, используемые для предотвращения переобучения (overfitting)․ К ним относятся dropout, L1 и L2 регуляризация․

- Нормализация данных⁚ Преобразование данных для улучшения процесса обучения․ Часто используется нормализация данных (например, z-score normalization)․

- Подбор гиперпараметров⁚ Настройка параметров обучения, таких как скорость обучения (learning rate), размер батча (batch size) и количество эпох (epochs)․ Этот процесс часто требует экспериментирования и использования методов поиска гиперпараметров (например, Grid Search, Random Search)․

Понимание этих аспектов критически важно для успешного обучения нейронных сетей и достижения высоких результатов в различных задачах․

Sveiki, aš norėjau sužinoti jūsų kainą.